| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

- flow matching

- 논문리뷰

- inversion

- Programmers

- memorization

- 네이버 부스트캠프 ai tech 6기

- 코테

- flow matching models

- BOJ

- diffusion model

- unlearning

- ddim inversion

- 3d generation

- Python

- diffusion models

- flow models

- rectified flow matching models

- image editing

- video generation

- rectified flow models

- visiontransformer

- diffusion

- Machine Unlearning

- VirtualTryON

- 3d editing

- image generation

- 프로그래머스

- Concept Erasure

- rectified flow

- video editing

- Today

- Total

평범한 필기장

[평범한 청강생의 논문 맛보기] Visual Autoregressive Modeling: Scalable Image Generation via Next-Scale Prediction (VAR) 본문

[평범한 청강생의 논문 맛보기] Visual Autoregressive Modeling: Scalable Image Generation via Next-Scale Prediction (VAR)

junseok-rh 2024. 4. 15. 17:43주재걸 교수님의 DAVIAN Lab에서 진행하는 computer vision study를 청강하게 되었다. 최신 논문들을 다루는 것 같아서 따라가기 힘들겠지만 최대한 스터디 전에 간단하게 어떤 논문인지 맛보고 스터디 청강을 해야겠다는 생각이 들었다. 그래서 이 스터디에서 읽을 논문들은 최대한 어떤 논문인지 간단하게만 정리해보려고 한다.

이번 주의 논문은 "VAR"이다.

https://arxiv.org/abs/2404.02905

Visual Autoregressive Modeling: Scalable Image Generation via Next-Scale Prediction

We present Visual AutoRegressive modeling (VAR), a new generation paradigm that redefines the autoregressive learning on images as coarse-to-fine "next-scale prediction" or "next-resolution prediction", diverging from the standard raster-scan "next-token p

arxiv.org

1. Introduction

요즘 LLM모델들이 AR방식으로 성공을 했는데, 이 방식을 Image Generation에서도 써보자!하는 아이디어에서 나온듯하다. 거대한 AR 모델들의 성공에 대한 연구에서 강조한 것은 바로 scalability와 generalizability이다.

- Scalability : scaling law에서 볼 수 있음. 거대한 모델의 성능을 작은 모델로부터 예측.

- Generailizability : zero-shot, few-shot learning에서 볼 수 있음.

이러한 특징들은 거대한 unlabel된 데이터로부터 학습하는 AR 모델의 잠재력을 드러낸다. DALL-E와 VQGAN과 같은 이미지 생성을 하는 AR모델들이 존재했지만 diffusion model들에 비해 성능이 떨어진다.

Autoregressive modeling은 데이터의 order를 정의할 필요가 있다. 본 논문에서는 이미지를 어떻게 'order'할 건지를 다시 고려한다. 사람은 이미지의 global한 구조를 먼저 인지하고 그 다음 local한 디테일을 본다. 이러한 multi-scale, coarse-to-fine 방식이 이미지의 "order"를 제안한다. 본 논문에서는 아래 이미지의 (c)에서 "next-scale prediction"으로 이미지를 학습시키는 autoregressive model을 정의한다.

본 논문의 방식은 이미지를 multi-scale token map으로 encoding하는 것에서 시작한다. Autoregressive process는 1*1 token map에서 점진적으로 해상도를 확장한다. 각 스텝에서 transformer는 이전의 token map들을 condition으로 다음 해상도의 token map을 예측한다. 이를 Visual AutoRegressive(VAR) modeling이라고 한다.

2. Method

Formulation

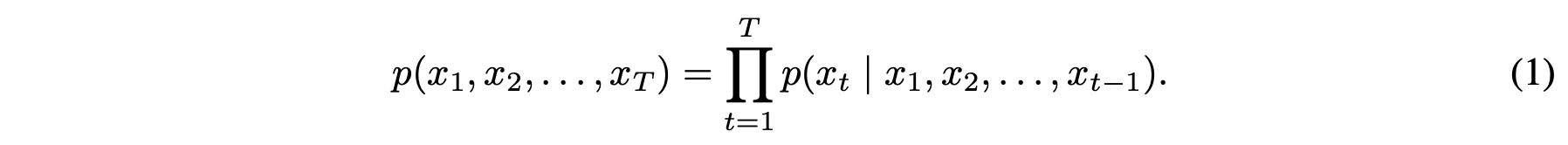

기존의 autoregressive(AR) model은 "next token prediction" 전략이었다. 현재 토큰 $x_t$는 $(x_1,x_2,\cdots, x_{t-1})$에만 의존한다.

본 논문에서는 "next token prediction"에서 "next scale prediction" 전략으로 바꾼다. 본 논문에서는 feature map$f \in \mathbb{R}^{h \times w \times C}$를 K multi-scale token maps $(r_1,r_2,\cdots,r_K)$으로 양자화하면서 시작한다. Autoregressive likelihood는 아래와 같이 수식화 된다.

k번째 autoregressive step동안, $r_k$에서 $h_k \times w_k$ 토큰들에 대한 모든 분포는 inter-dependent이고 병렬적으로 생성된다. 그리고 이는 $r_k$의 prefix $(r_1, \cdots, r_{k-1})$에 condition되고, k번째 position embedding map에 연관된다.

이 "next-scale prediction"을 visual autoregressive modeling(VAR)이라고 정의한다.

Tokenization

Next token prediction을 통해 이미지에 autoregressive modeling을 적용시키기 위해, 1) 이미지를 discrete한 토큰들로 tokenize해야하고, 2) unidirectional modeling을 위해 토큰들의 1D order를 정의해야한다.

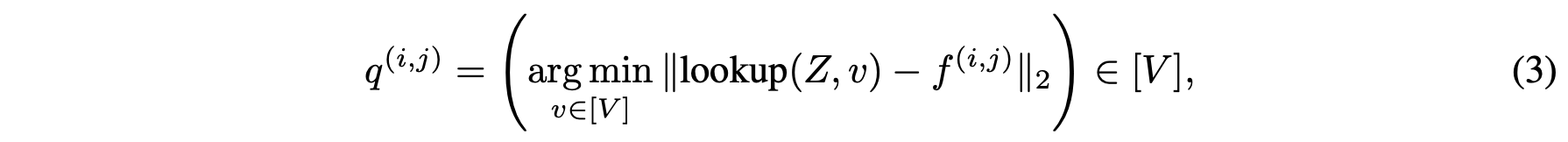

식 (2)를 통해 이미지에서 feature map을 뽑고, 그 feature map을 양자화한다.양자화하는 과정은 식 (3)방식을 통해 이루어진다. 식 (4),(5)를 통해 quantized autoencoder를 학습시킨다. 이렇게 학습된 $\{ \mathcal{E}, \mathcal{Q}, \mathcal{D} \}$은 unidirectional autoregressive model을 학습시키위해 이미지를 tokenize하는데 사용된다.

이미지 토큰들의 order는 unidirectional autoregressive learning을 위해 외부적으로 정의가 되어져야한다. 그래서 flatten을 시켜준다.

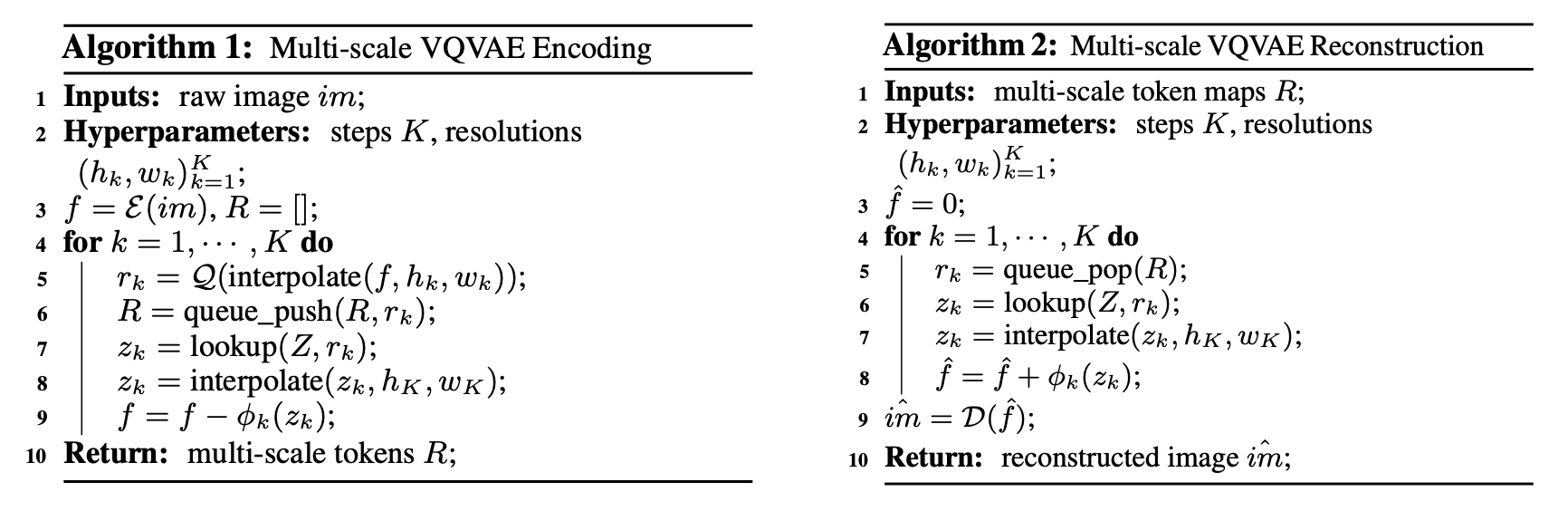

본 논문에서는 VAR을 학습시키기위한 이미지를 K multi-scale discrete token maps $R = (r_1,r_2,\cdots,r_K)$로 encode하는 새로운 multi scale quantization autoencoder를 개발한다. Encoding과 decoding 절차는 아래의 방식으로 이루어진다. 그리고 $z_k$를 $h_K \times w_K$로 upscaling을 할 때 정보 손실을 다루기위해, 본 논문에서는 K개의 extra convolution layers $\{ \phi_k \} ^K_{k=1}$를 사용한다.

Discussion

하지만 이렇게 tokenize하고 flatten하는 것에는 몇가지 문제점을 야기한다.

- Mathematical premise violation. Quantizing과 flattening 후에 토큰들의 시퀀스에 bidirectional correlations가 나타난다.

- Structural degradation. Flattening은 image feature maps에서 공간적인 locality를 파괴한다.

- Inefficiency.

1번 문제는 위에서 next-token prediction에서 next-scale prediction으로 바꿈으로써 해결이 된다. 2번 문제는 VAR에서는 flattening이 이루어지지 않고, 각 $r_k$안 토큰들은 fully correlate됐기 때문에 spatial locality는 보존되기에 해결된다. 3번 문제는 각 $r_k$에서 parallel token generation으로 efficiency가 얻어지기에 해결된다고 한다.

3. Empirical Results

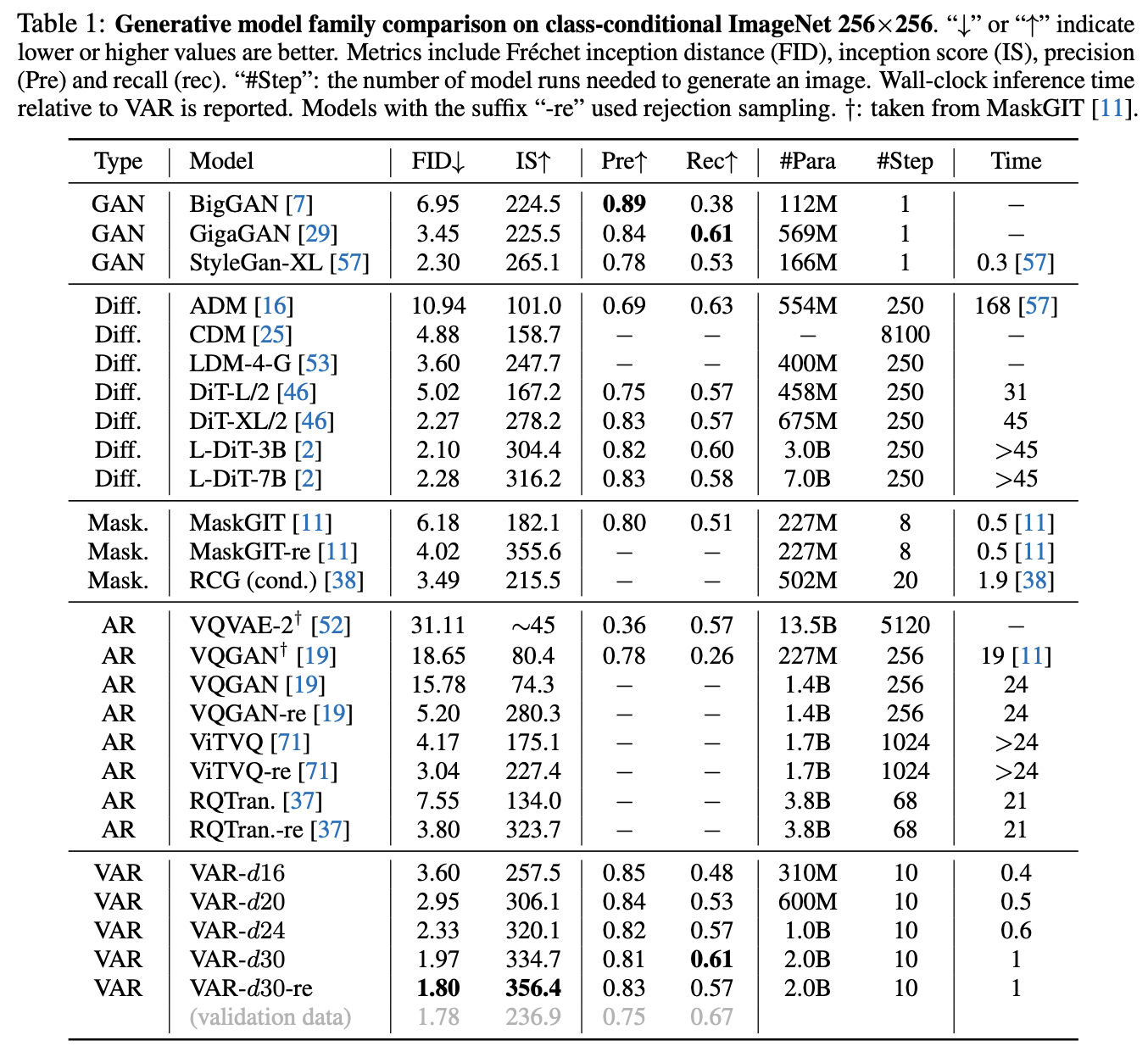

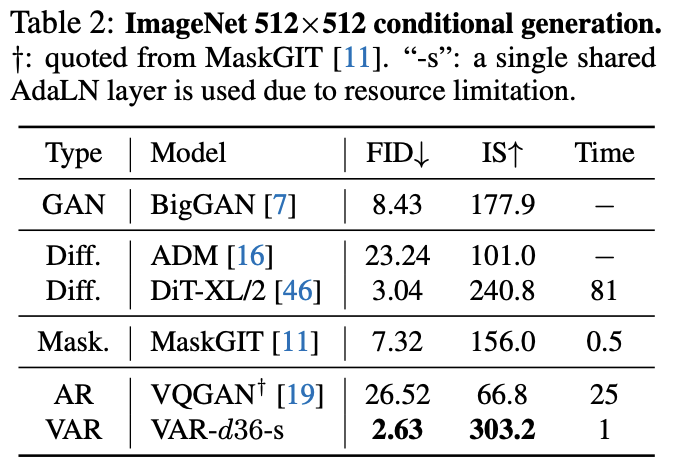

3.1 State-of-the-art image generation

VAR은 가장 높은 FID/IS를 얻었을 뿐만 아니라 이미지 생성 시간도 놀랍다. 또한 precision과 recall도 좋게 나왔다.

VAR이 처음으로 diffusion model을 이긴 autoregressive model이라고 한다. 위 결과들을 보면 VAR은 DiT와 같은 모델들보다 image generation에서 더 효율적이고 scalable한 모델이라고 할 수 있다.

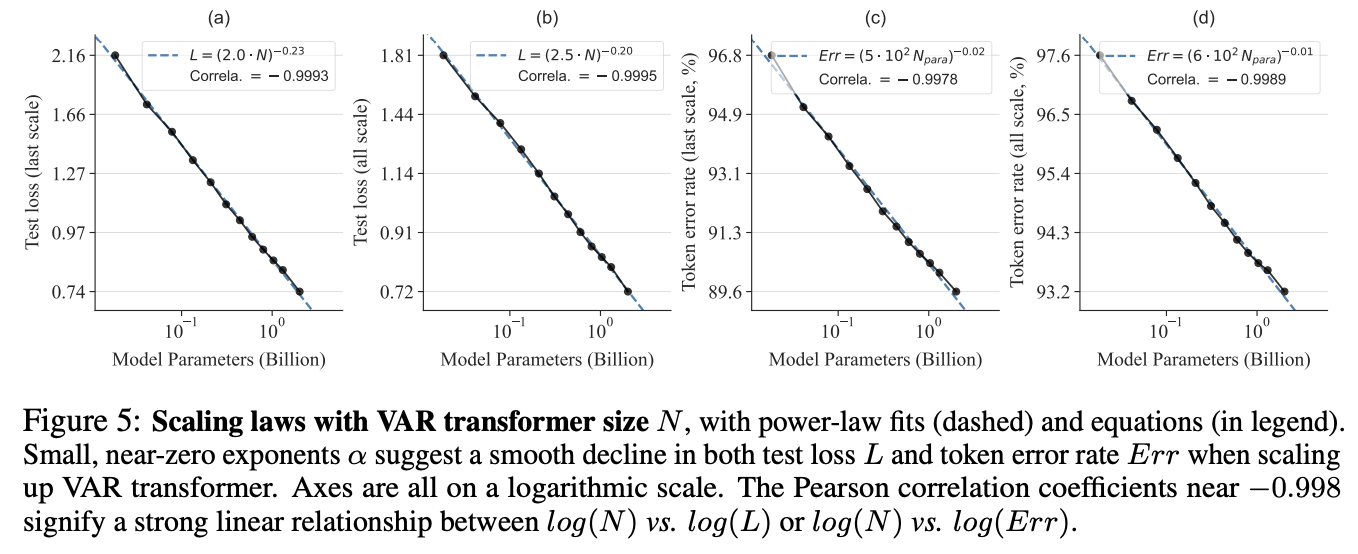

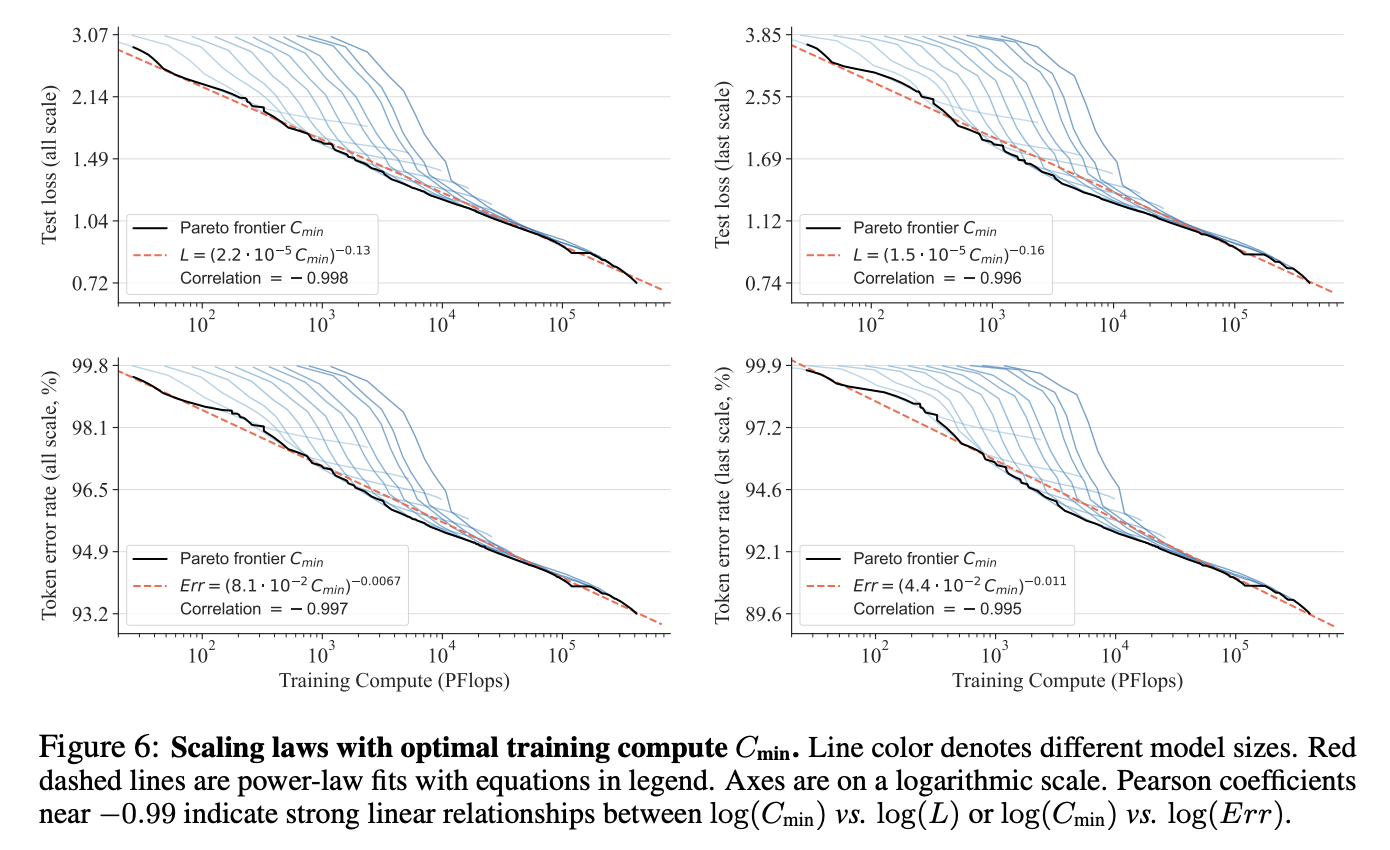

3.2 Power-law scaling laws

위 결과를 통해 VAR transformer를 키울수록 계속 모델의 test performance를 향상시킬 수 있다.

위 결과를 통해 더 큰 VAR transformer는 더 적은 computation을 통해 동일한 수준의 performance에 도달하기 때문에 더 compute-efficient하다는 것을 알 수 있다.

3.3 Zero-shot task generalization

3.4 Ablation Study

4. Conclusion

본 논문은 VAR이라는 모델을 도입했는데, 이는 image autoregressive model들에 내재된 몇 문제를 이론적으로 해결했고, language-model-based AR model이 처음으로 이미지 퀄리티, 다양성, 데이터 효율성, 추론 속도에서 diffusion model을 이긴 첫 모델이다.

백그라운드가 부족해서 완벽히 이해하지는 못한 것 같다ㅠㅠ 그래도 대충 큰 틀은 이해했으니 스터디 발표를 들으면서 이해가 부족한 부분을 보완할 수 있을 것 같다. 이번 주가 첫 청강인데 뭔가 설렌다 ㅎㅎ