Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | ||||||

| 2 | 3 | 4 | 5 | 6 | 7 | 8 |

| 9 | 10 | 11 | 12 | 13 | 14 | 15 |

| 16 | 17 | 18 | 19 | 20 | 21 | 22 |

| 23 | 24 | 25 | 26 | 27 | 28 | 29 |

| 30 | 31 |

Tags

- video editing

- Programmers

- BOJ

- DP

- 코테

- segmenation map generation

- video generation

- flow matching

- 코딩테스트

- image editing

- inversion

- score distillation

- 프로그래머스

- transformer

- dreammotion

- visiontransformer

- Python

- Vit

- 네이버 부스트캠프 ai tech 6기

- masactrl

- 논문리뷰

- segmentation map

- emerdiff

- rectified flow

- VirtualTryON

- diffusion

- diffusion models

- diffusion model

- 3d editing

- 3d generation

Archives

- Today

- Total

목록selfattention (1)

평범한 필기장

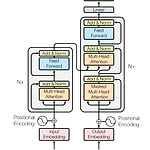

[평범한 학부생이 하는 논문 리뷰] Attention is all you need (Transformer)

[평범한 학부생이 하는 논문 리뷰] Attention is all you need (Transformer)

Transformer 자체는 이 전에 CS231n으로 대충 공부는 해봤지만 그래도 중요한 논문이기에 논문 자체를 읽어봐야겠다는 생각을 했었다. 이번 방학 때 시간이 되어 논문을 읽어보고 블로그에도 정리해보는 시간을 가졌다. 이번 논문 리뷰는 나동빈님의 논문 리뷰영상과 자료를 많이 참고해서 작성했다.https://arxiv.org/abs/1706.03762 Attention Is All You NeedThe dominant sequence transduction models are based on complex recurrent or convolutional neural networks in an encoder-decoder configuration. The best performing models als..

AI/Etc.

2023. 8. 25. 15:39