| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | ||||

| 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| 11 | 12 | 13 | 14 | 15 | 16 | 17 |

| 18 | 19 | 20 | 21 | 22 | 23 | 24 |

| 25 | 26 | 27 | 28 | 29 | 30 | 31 |

- rectified flow

- unlearning

- image generation

- video editing

- inversion

- flow matching

- video generation

- flow models

- 3d generation

- Machine Unlearning

- Programmers

- diffusion model

- Concept Erasure

- 프로그래머스

- image editing

- flow matching models

- 네이버 부스트캠프 ai tech 6기

- memorization

- diffusion

- 3d editing

- Python

- visiontransformer

- ddim inversion

- BOJ

- VirtualTryON

- rectified flow matching models

- rectified flow models

- diffusion models

- 코테

- 논문리뷰

- Today

- Total

평범한 필기장

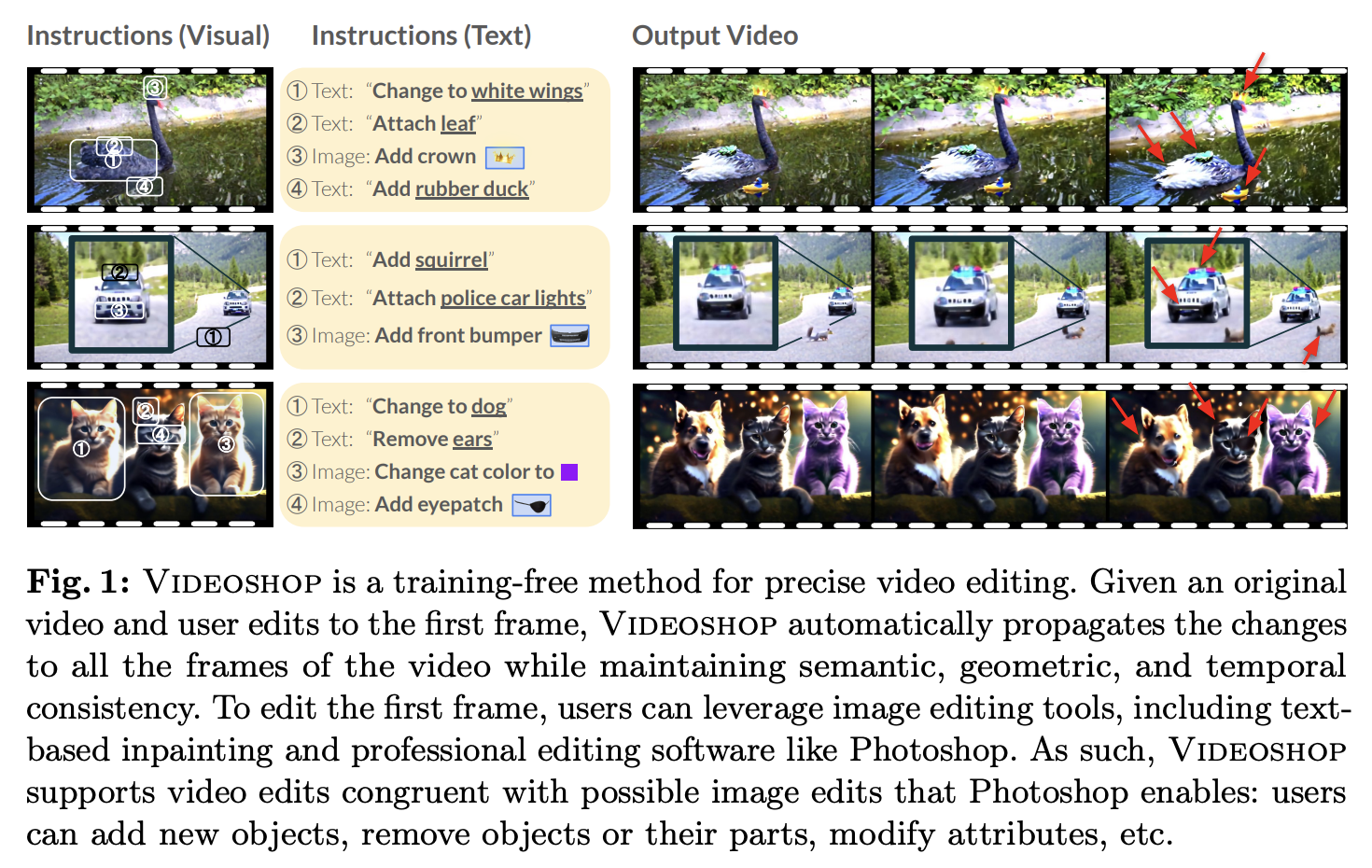

[평범한 학부생이 하는 논문 리뷰] VIDEOSHOP : Localized Semantic Video Editing with Noise-Extrapolated Diffusion Inversion (ECCV 2024) 본문

[평범한 학부생이 하는 논문 리뷰] VIDEOSHOP : Localized Semantic Video Editing with Noise-Extrapolated Diffusion Inversion (ECCV 2024)

junseok-rh 2024. 10. 29. 22:48Paper : https://arxiv.org/abs/2403.14617v3

Videoshop: Localized Semantic Video Editing with Noise-Extrapolated Diffusion Inversion

We introduce Videoshop, a training-free video editing algorithm for localized semantic edits. Videoshop allows users to use any editing software, including Photoshop and generative inpainting, to modify the first frame; it automatically propagates those ch

arxiv.org

0. Abstract

본 논문은 새로운 video editing method VIDEOSHOP을 제안한다. 비디오의 첫 프레임을 editing하면 그 변경 사항을 다음 프레임들에 전달하는 방식?인 것 같다. 본 논문은 noise extrapolation으로 latent를 inverting하는 것으로 image-based video editing을 하는 방식인데 여기서 "inverting latent with noise extrapolation"이 본 논문의 key idea나 method인 것 같다.

1. Introduction

기존에 video를 editing을 하기 위해서는 Adobe Premiere와 같은 툴들을 사용했는데, 이러한 툴들은 한 frame을 editing하면 그 사항들이 다른 frame에 propagating되지 않는다. 그래서 모든 frame을 수정해야한다는 단점이 있다.

또한 기존의 video editing model들은 정확한 localized semantic editing 용이하게 하는데 단점을 지닌다. 그리고 각각의 video들에 대해 fine-tuning되는 것이 필요로 되어지거나 specificity가 부족한 coarse textual instructions에 의존한다는 단점 또한 지닌다. 게다가 independent motion을 가진 새로운 객체를 도입하는데 어려움을 갖는다.

Image editing을 이용해서 video editing을 하는 것에서는 video frame에 따른 temporal consistency를 보장하지 못한다.

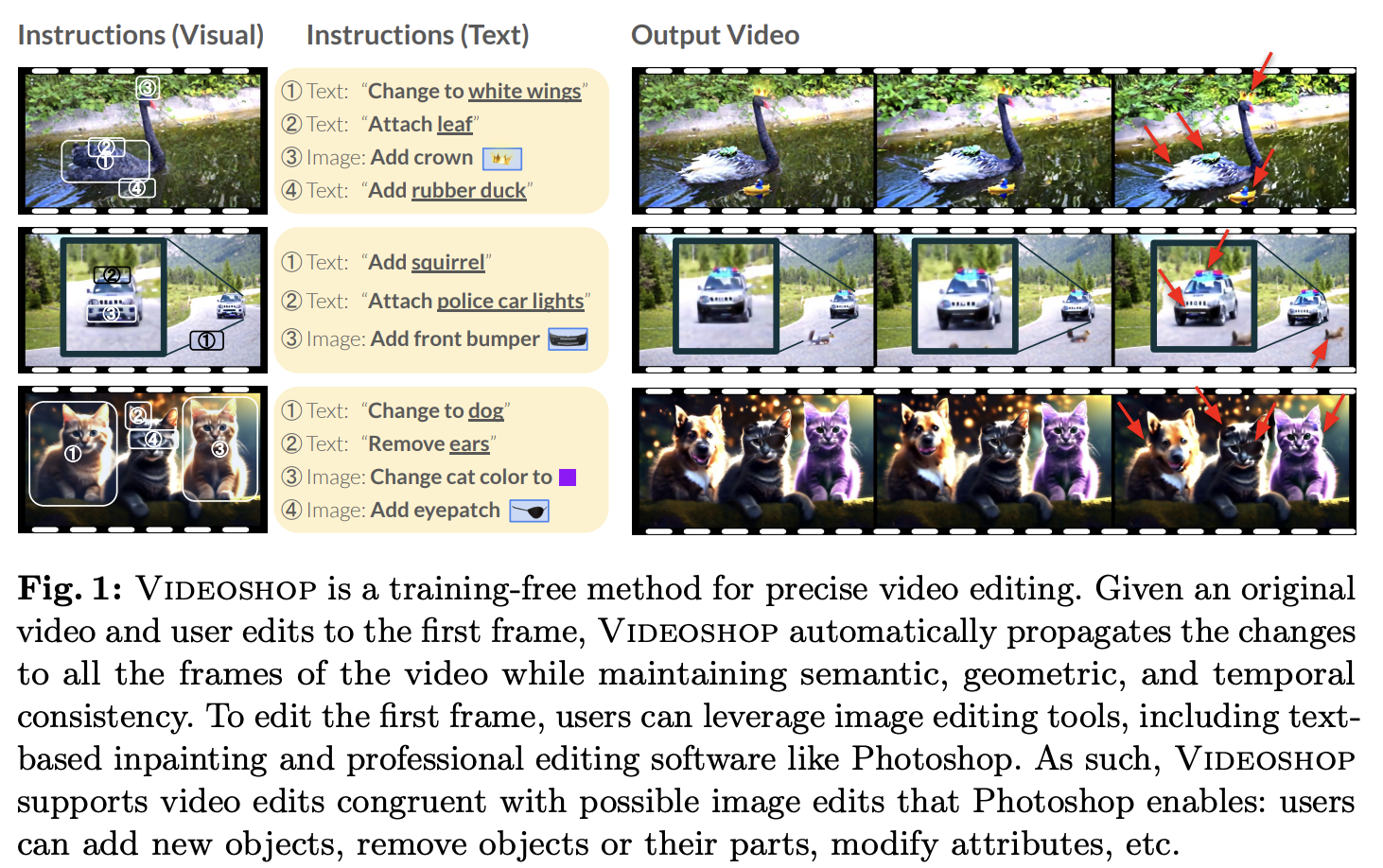

이러한 기존 방식들의 문제점을 해결하기 위해서 본 논문에서는 VIDEOSHOP을 도입한다. 이는 localized semantic edit을 가능하게 하는 training-free video editing algorithm이다. 이 메서드는 유저가 어떤 방식으로든 간에 첫 frame을 수정하면 이를 다른 frame에 propagating하는 것이다. 또한 finetuning을 필요로 하지 않고 editing을 하는데 Stable Video Diffusion을 사용한다.

DDIM inversion에서 현재 timestep의 latent를 사용해서 다음 timestep에서의 노이즈를 approximate한다. 본 논문에서는 이 approximation이 image-to-video diffusion에서 단지 첫번째 frame만 정확하게 reconstruction하고, 이는 누적되는 approximation error들때문에 불안정적인 latent를 이끈다는 것을 발견했다. 본 논문은 denoising process동안 latents가 near-linear라는 것을 드러낸다. 본 논문은 이 관찰을 이용하고 inversion with noise extrapolation을 도입한다. 이는 어떠한 video에서라도 faithful reconstruction을 이루도록하는 매커니즘이다. 또한 본 논문은 video latents는 unnormalize됐고 이는 instability를 이끈다는 것을 드러낸다. 본 논문은 consistency와 quality를 보장하는 latent normalization technique를 도입한다.

VIDEOSHOP은 10개의 평가 메트릭에서 6개의 베이스라인보다 더 좋은 결과를 보인다. 또한 geometric fidelity를 보장할 뿐만 아니라 realistic motion을 잘 capture한다.

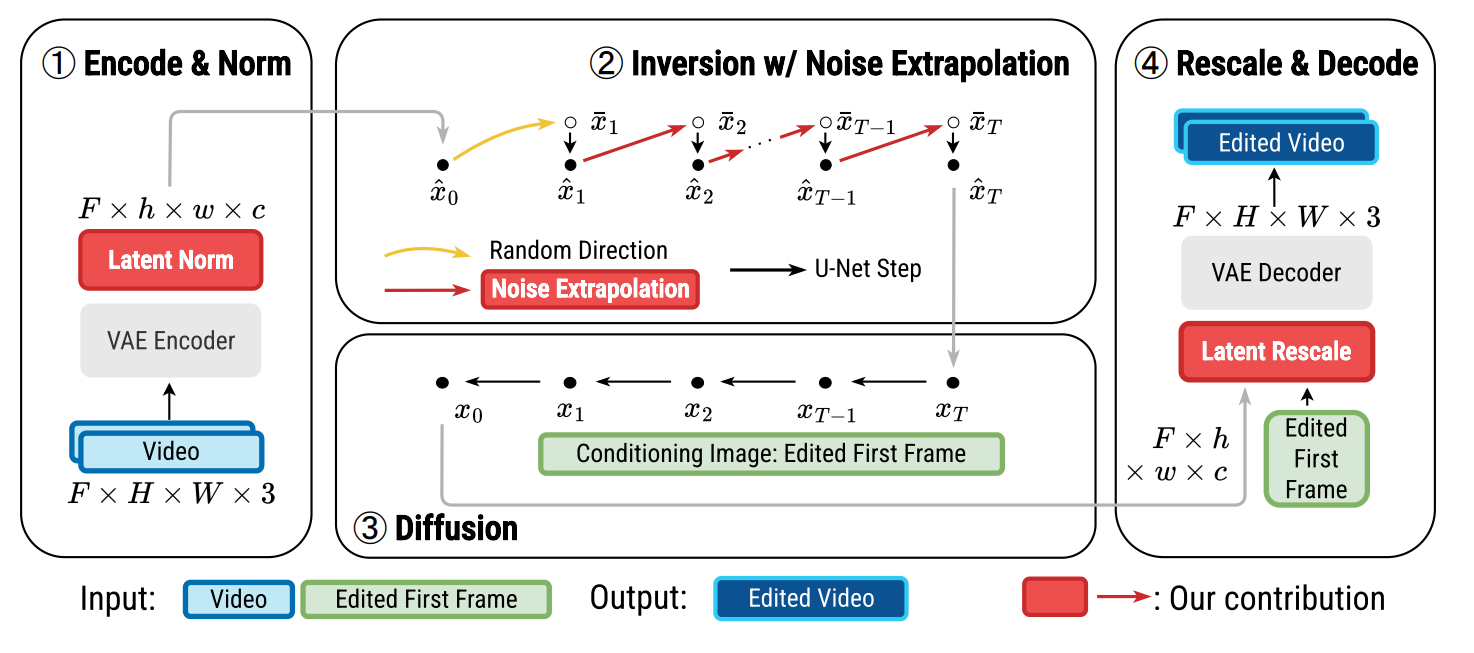

2. Method

Input video $\mathcal{V}$와 edited first fram $\mathcal{I}$가 주어지면, first frame에서의 변화는 전파하면서 원래 video의 전체적인 움직임과 semantics를 보존하는 새로운 video $\mathcal{J}$를 생성하는 것이 목표이다.

2.1 Background on diffusion inversion

본 논문에서는 단순히 video latents를 inverting하는 것은 incoherent video를 생성하는 것을 관찰했다.

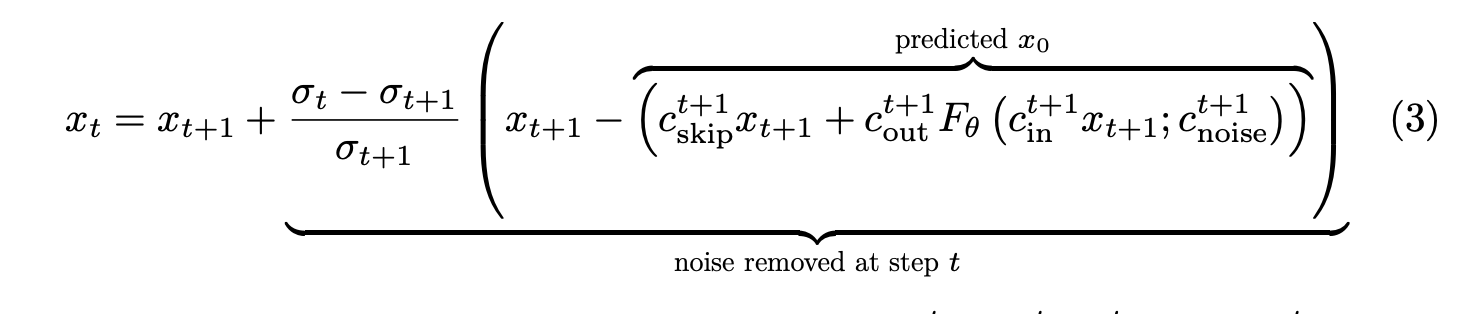

2.2 Background on the EDM framework

EDM framework에서의 deterministic sampling의 $x_{t+1} \rightarrow x_t$으로의 denoising step은 다음 수식처럼 표현된다.

$\sigma_t$는 $t$에서의 scheduled noise level이고, $c^t_{skip}, c^t_{in}, c^t_{out}$, $c^t_{noise}$는 noise schedule과 timestep $t$에 dependent한 coefficient들이다. $F_\theta$는 neural network이다.

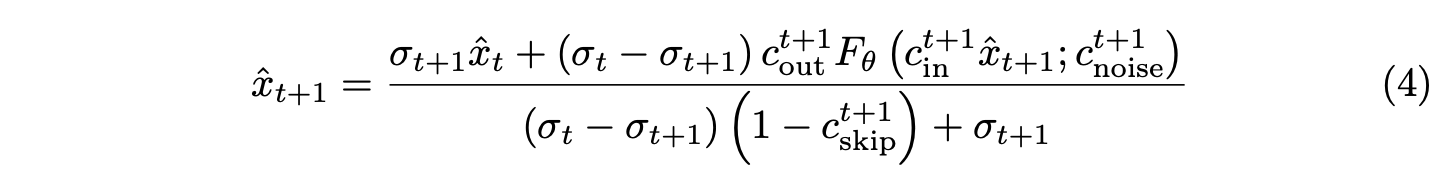

이를 가지고 inversion을 수행하기 위해서는 수식 (3)을 다음과 같이 쓸 수 있다.

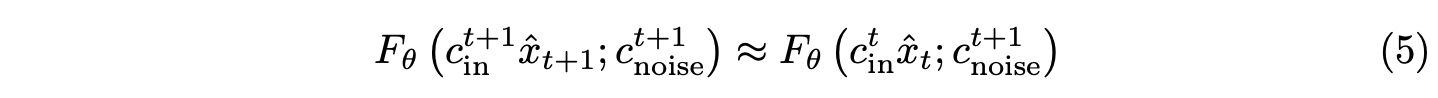

여기서 문제는 $F_\theta$는 $\hat{x}_{t+1}$에 의존하기 때문에, 바로 풀 수 없다는 것이다. 그래서 naive inversion은 다음과 같은 approximation methods를 이용한다.

2.3 Limitations with naive video inversion to EDM

수식 (5)를 이용한 방식을 Stable Video Diffusion모델에 적용하면, 첫번째 video frame만 정확하게 reconstruction하는 latents를 이끈다. 본 논문에서는 이 방식이 compounding approximation error를 가지고오기 때문이라는 것을 저자들은 관측했다고 한다.

이러한 문제점을 해결하려는 연구들이 있었지만 inversion process에서 latents를 destabilize하고 undesirable artifacts를 가져온다는 것 또한 본 논문의 저자들이 발견했다고 한다.

2.4 Contribution : Inverting with noise extrapolation

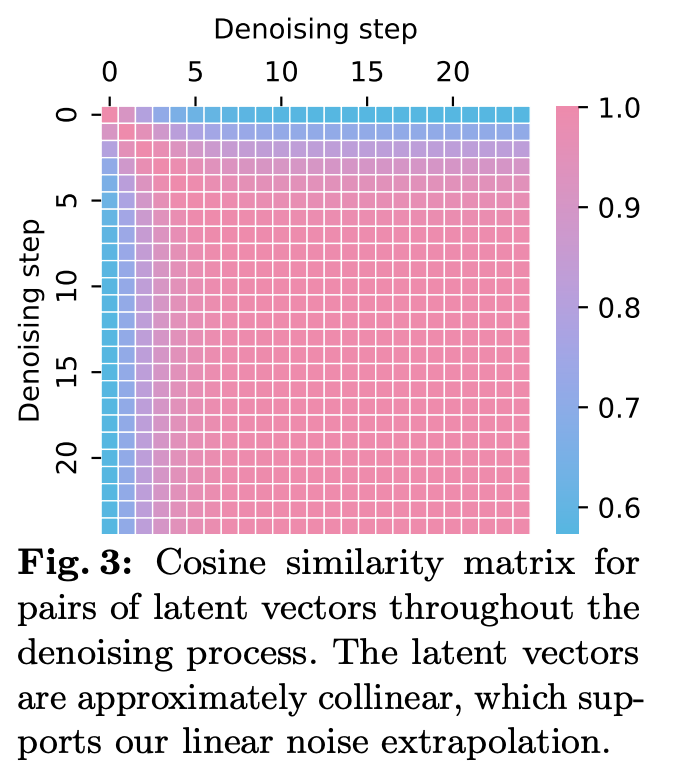

$F_\theta(c^{t+1}_{in} \hat{x}_{x+1} ; c^{t+1}_{noise})$의 더 좋은 근사치를 찾음으로써 위에서 지적한 문제를 해셜할 수 있고, 이것이 본 논문의 목적 중 하나라고 할 수 있다. 첫째로 본 논문은 denoising process에서 latents가 near-linear trajectory를 유지한다는 것을 관찰했다. 이 관찰을 이용하기 위해 본 논문은 noise extrapolation을 제안한다.

Near-linearity of $x_t$ trajectory

위의 결과를 보면 초기 스텝 후에는 denoising step에 따른 cosine similarity가 높은 것을 볼 수 있다. 이는 low noise level 이후에는 $x_t$의 trajectory는 거의 linear하다는 것을 보여준다.

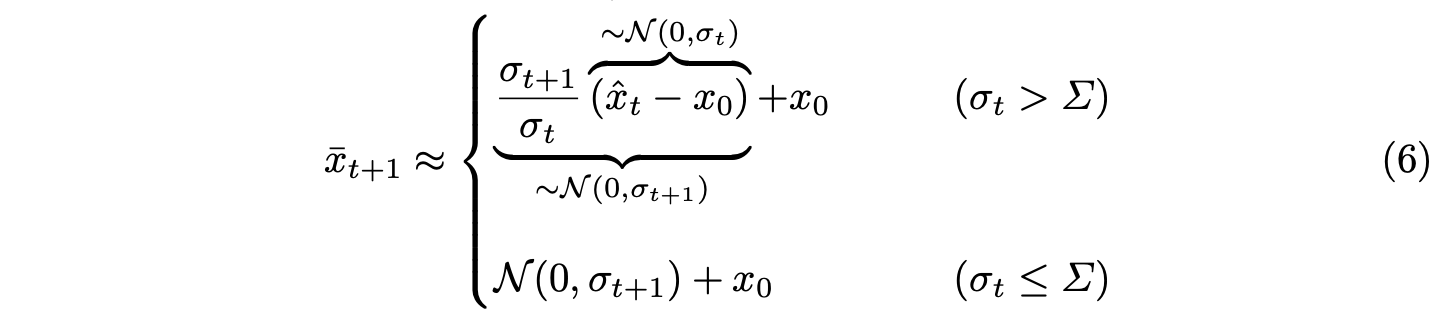

Noise extrapolation

위 insight를 이용해서, $F_\theta$에 제공할 $\bar{x}_{t+1}$의 근사치를 얻기 위해 $\hat{x}_{t+1}$에서의 noise를 다음과 같이 linear하게 extrapolate한다.

여기서 $\Sigma$는 noise level에 대한 threshold이다. $\sigma_t$가 작으면 작은 값으로 나누기 때문에 large noise를 야기하고, 이는 latent를 destabilize한다.

이를 가지고 수식 (4)를 수정해서 $\bar{x}_{t+1}$를 이용해서 inversion을 다음과 같이 추정한다.

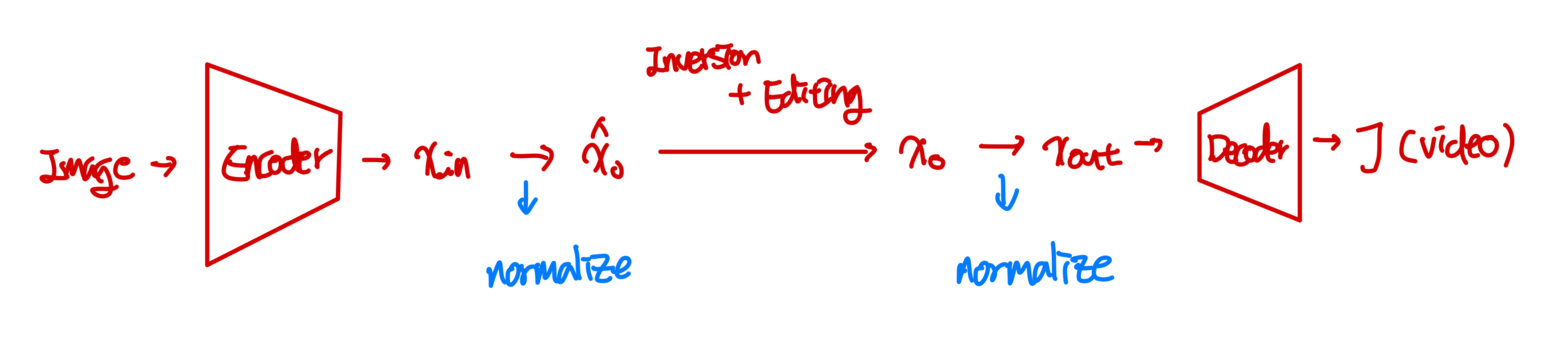

이를 이용해서 $\hat{x}_T$를 얻고 edited image $\mathcal{I}$를 condition으로 denoising process를 거쳐서 edited latents $x_0$를 얻는다.

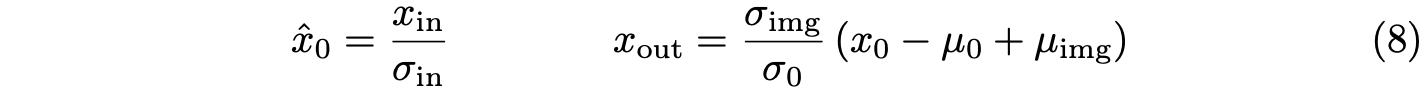

2.5 Contribution : Latent normalization and rescaling

Introduction에도 나와있듯이 VAE encoder로부터 바로 나온 output은 unnormalize됐기에, 이는 inversion process로부터의 final latent의 magnitude에 대해 large variance를 야기한다. 이는 생성된 video에 대한 poor quality를 야기한다고 한다. 이를 해결하기 위해, inversion process의 시작 전에 latents를 normalize하는 것을 제안한다.

여기서 $\mu_{img}, \sigma_{img}$는 VAE encoder를 통해 encoding된 target image(edited first frame)의 latents의 평균과 표준편차이다. 모든 normalization은 per-channel로 행해지고, $\sigma_{in}$는 모든 프레임에 걸쳐 계산되어지고 $\mu_0, \sigma_0, \mu_{img}, \sigma_{img}$는 first frame에 대해 계산된다.

전체 아키텍쳐는 다음과 같다.

3. Experiments and Results

실험 결과 요약

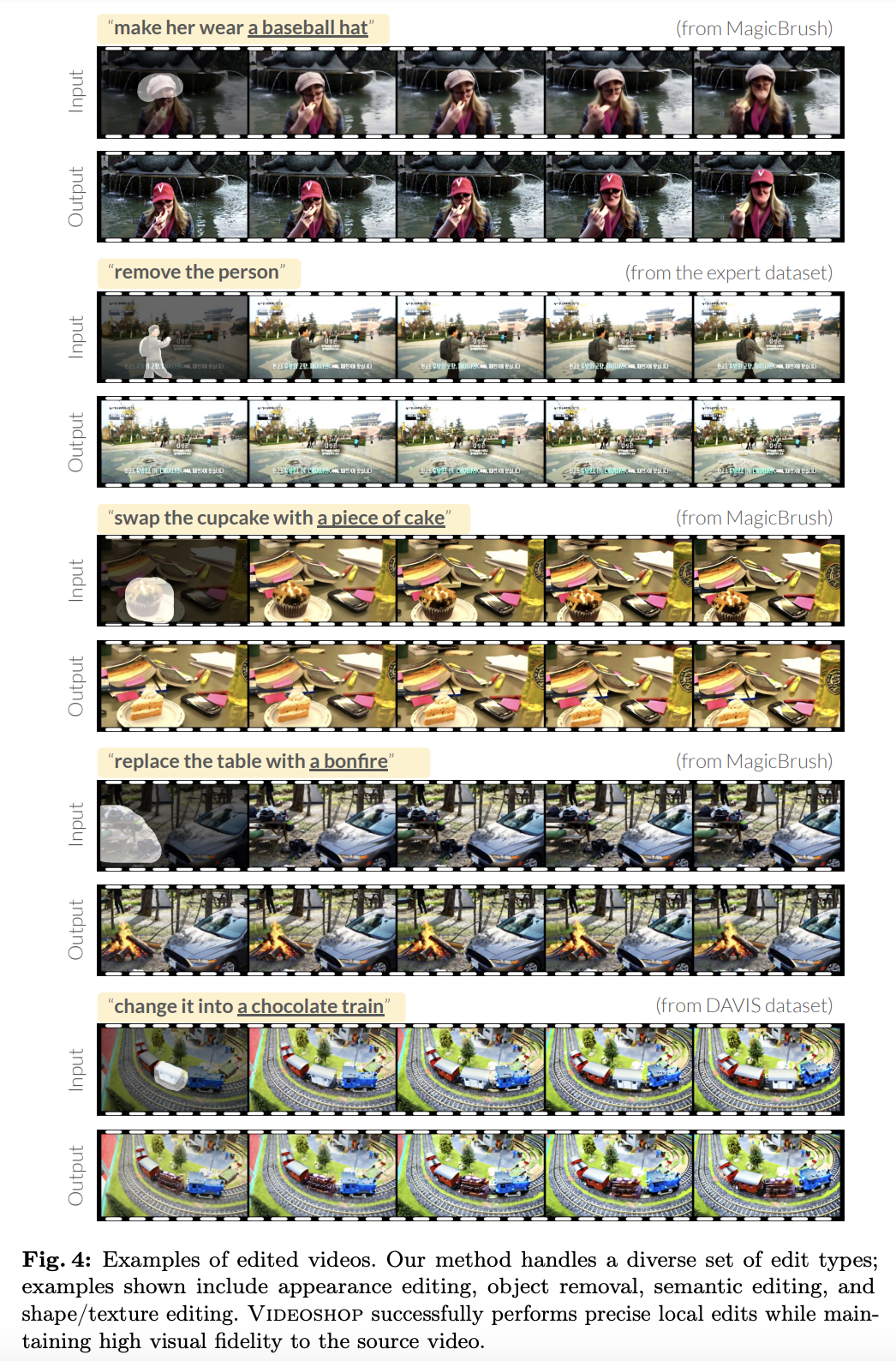

- 다양한 종류의 editing에 대해서 성공적으로 localized semantic video editing을 수행했다.

- 기존의 방식들은 source video와 target edit에 대한 visual fidelity를 유지하는데 명백한 한계를 보였다.

- 높은 temporal consistency를 유지하면서 edit fidelity와 source faithfulness에 대한 평가에서 SOTA를 달성했다.

- User study에서도 다른 text-based video editing 방식들을 능가했다.

- 평균적으로 baseline에 비해 x2.23의 speedup을 보여 효율적이다.

Video editing capabilities of VIDEOSHOP

다양한 종류의 video editing 결과를 보여준다. 결과를 보면 본 논문의 method는 source video의 높은 visual fidelity를 유지하면서 정확한 local edits, appearance control, independent object addition을 성공적으로 수행한다.

Limitations of existing methods

위 결과들을 볼 때, 기존의 다른 모델들은 종종 source video와 target edit에대한 visual fidelity를 유지하는데 실패한다.

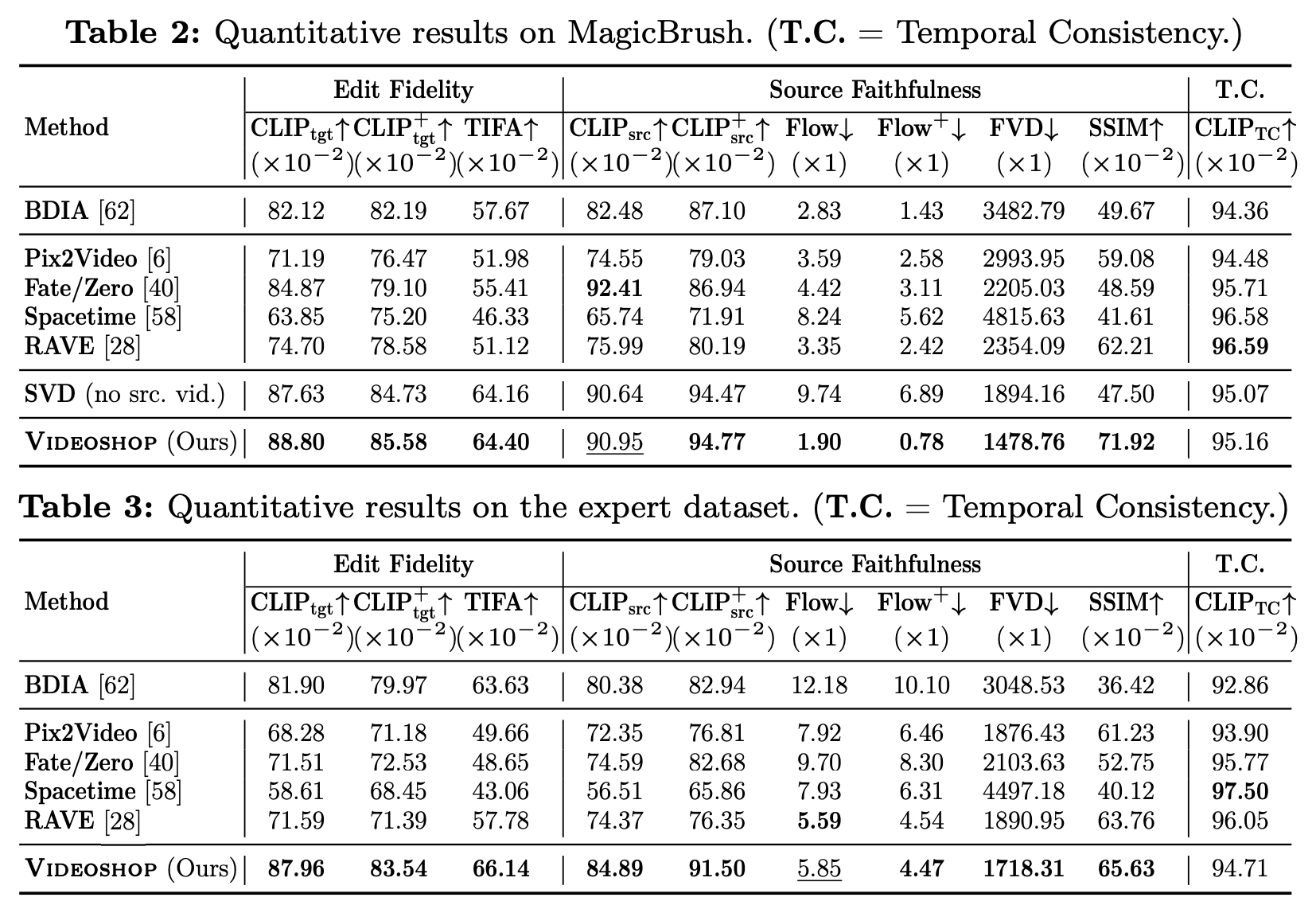

Automated Evaluation

1. Edit Friendly

- $CLIP_{tgt}$ : editing된 각 프레임과 target image간의 CLIP embedding 유사도 계산

- $CLIP_{tgt}^+$ : CoTracker를 이용해서 수정된 부분에만 집중

- TIFA score : target image와 edited video frame들 간의 semantic alignment를 평가

2. Source Faithfulness

- $CLIP_{src}$ : source와 target video 사이의 유사도

- $CLIP_{src}^+$ : editing되지 않은 부분에 대해서만 계산

- $Flow$ : motion faithfulness 측정. optical flow 비교를 통해 end-point error를 계산

- $Flow^+$ : editing되지 않은 부분에 대해서만 계산

- FVD, SSIM : quality 계산

3. Temporal Consistency

- $CLIP_{TC}$ : 연속적인 프레임들 사이의 CLIP 유사도 평균

위 결과를 보면 edit fidelity와 source faithfulness에서 거의 모든 지표에서 가장 좋은 성능을 보인다.

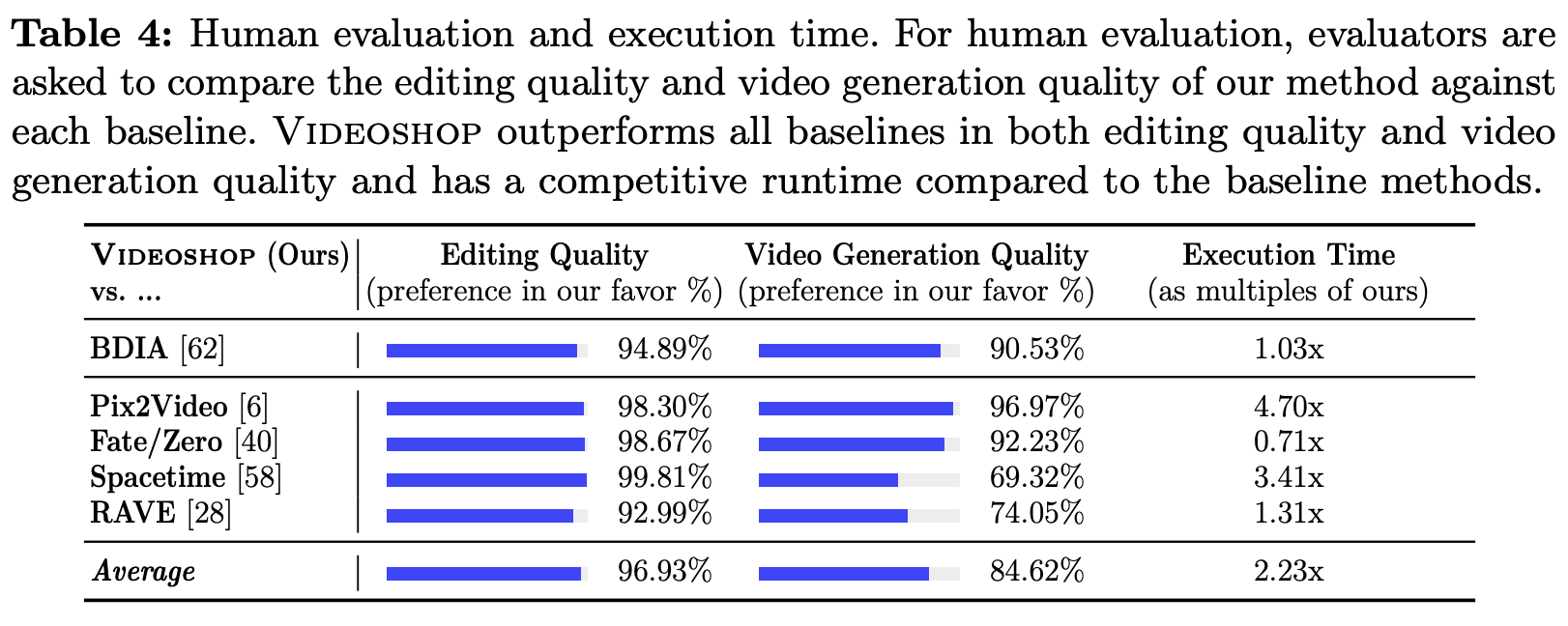

Human Evaluation & Efficiency

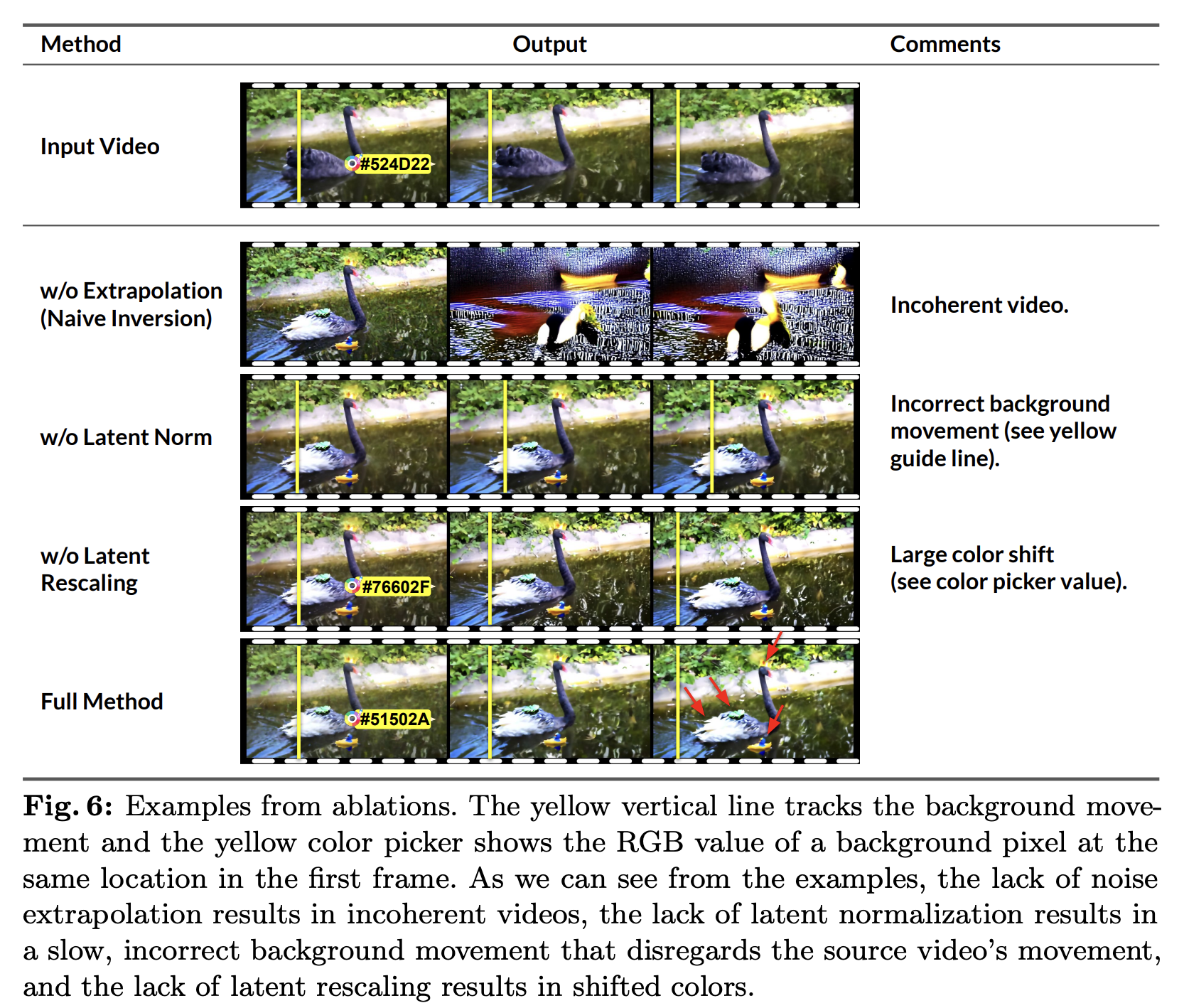

3.1 Ablation Study

위 결과를 보면 noise extrapolation이 없으면 incoherent video를 생성하고, normalization이 없으면 source video에서의 motion을 무시하는 느리고 부정확한 background movement를 야기한다. 그리고 rescaling이 없으면 shifted color를 야기한다.

Full model은 without norm을 제외하고 모든 ablation을 outperform한다. 그리고 앞에서 말했듯이 normalization은 꼭 필요하기에 Full model로 해야한다고 한다.

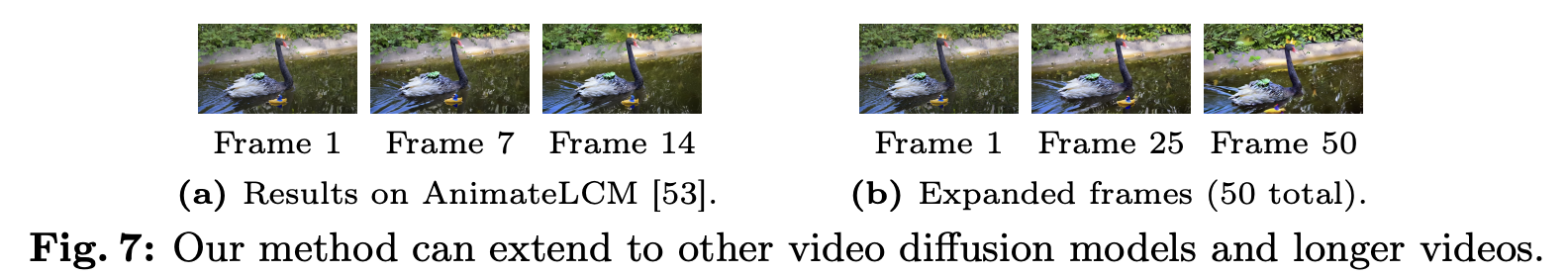

3.2 Extension to Other Models and Longer Videos

4. Discussion and Limitations

본 논문은 다음 세가지 limitation을 가진다.

- 본 논문의 method에 사용된 VAE는 video encoding 과정에서 정보 손실을 야기할 수 있다. 그래서 이는 몇 fine detail들을 생략할 수 있다.

- Source video가 large movement나 filckering을 가지는 경우, 본 논문 메서드의 temporal consistency는 저하될 수 있다.

- Training-free(base model의 knowledge만 사용)이기 때문에, 새로운 정보를 도입하는데 제한적이다.

본 논문의 메서드는 image-to-video model이 향상하면 더 효과적이 될 것이라고 예상된다.