| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- video generation

- DP

- inversion

- 코딩테스트

- 네이버 부스트캠프 ai tech 6기

- flipd

- video editing

- 3d editing

- flow matching

- transformer

- segmentation map

- 논문리뷰

- 3d generation

- diffusion

- masactrl

- rectified flow

- 코테

- segmenation map generation

- VirtualTryON

- 프로그래머스

- diffusion model

- image editing

- Vit

- diffusion models

- noise optimization

- Python

- visiontransformer

- memorization

- Programmers

- BOJ

- Today

- Total

평범한 필기장

[DEVOCEAN OpenLab] Follow Your Pose : Pose-Guided Text-to-Video Generation using Pose-Free Videos 본문

[DEVOCEAN OpenLab] Follow Your Pose : Pose-Guided Text-to-Video Generation using Pose-Free Videos

junseok-rh 2024. 5. 15. 01:13https://arxiv.org/abs/2304.01186

Follow Your Pose: Pose-Guided Text-to-Video Generation using Pose-Free Videos

Generating text-editable and pose-controllable character videos have an imperious demand in creating various digital human. Nevertheless, this task has been restricted by the absence of a comprehensive dataset featuring paired video-pose captions and the g

arxiv.org

1. Introduction

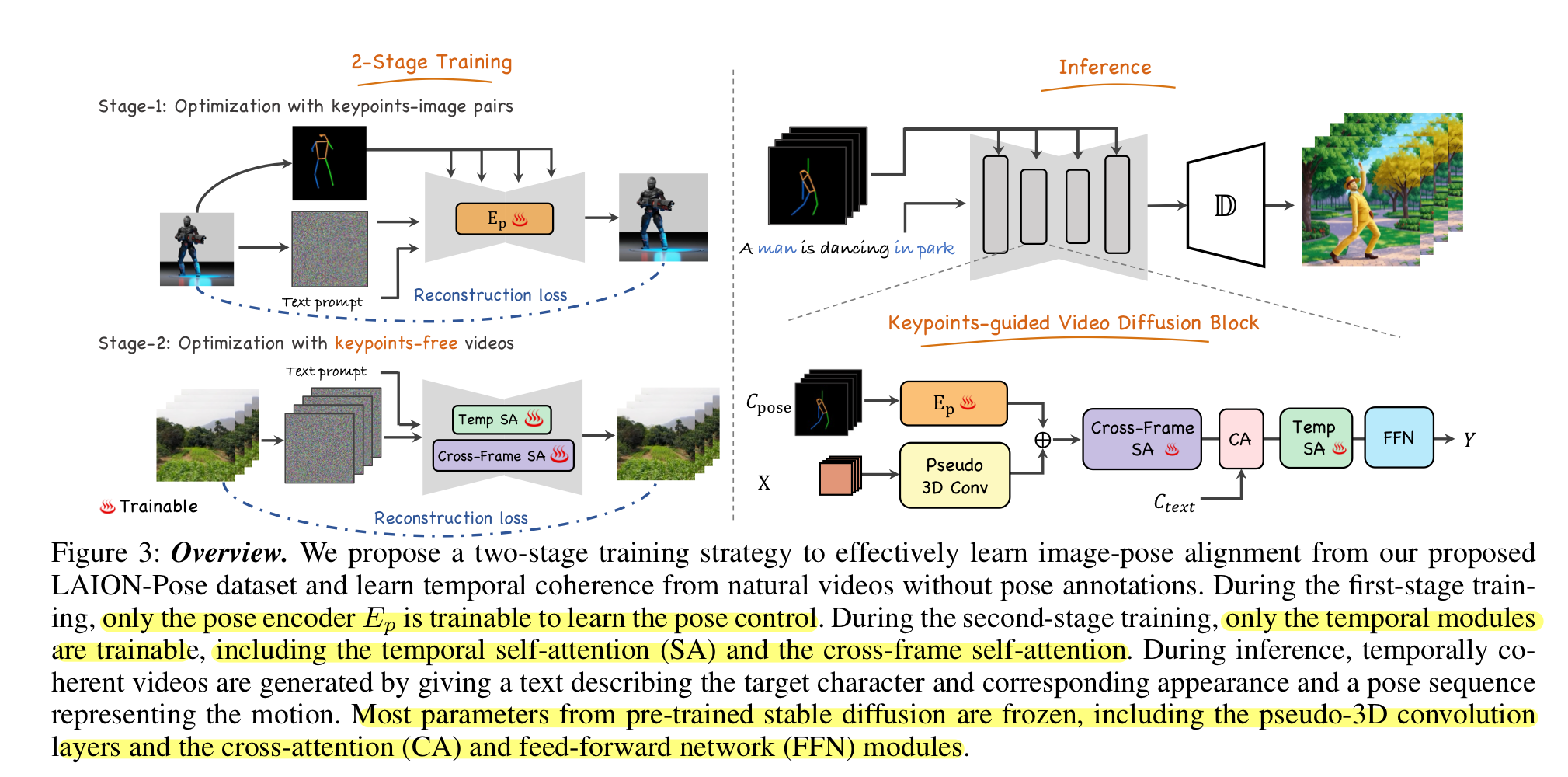

Text-to-Image generation의 발전으로 이러한 AI generative system은 다양한 분야에서 탁월하다. 하지만 text-to-video 생성에서는 high-quality video 데이터셋과 video generative prior model의 제약으로 적용에 제한을 지닌다. 본 논문에서는 text descriptions으로부터 높은 수준의 character video를 생성하고 주어진 control signal을 통해 그들의 pose를 control하는 것이 목표이다. 본 논문에서는 pretrain된 text-to-image model을 통해 새로운 two-stage training 전략을 제시한다. 첫 번째 stage에서, 추가 multi-layer pose encoder를 통해 pretrain text-to-image model에 control 능력을 더해준다. 두 번째 stage에서는 시간의 일관성을 학습하기 위해 model을 pose-free video로 학습시킨다. 또한 T2I model이 video input에 적합하도록 만들기 위해 몇 가지의 수정을 했다. i) extra temporal self-attention layer를 더한다. ii) 더 좋은 content consistency를 위해 attention을 cross-frame attention으로 reshape한다. 그러고 나서 본 논문에서는 pose control 없이 text-to-video generation tasks를 위해 video model을 fine-tune한다. 두 번째 stage의 학습동안, 본 논문에서는 temporal consistency와 연관된 파라미터들만 update하고 다른 파라미터들은 고정한다. Pose control은 pose encoder에 의해 보장되고 temporal 정보는 video 데이터셋과 잘 디자인된 temporal module에 의해 학습되어지기 때문에, 두 stages의 학습 후에는 본 논문의 method는 text-editable appearance와 함께 포즈를 컨트롤할 수 있는 캐릭터 video를 생성하는 것을 다룬다.

전체적으로, 본 논문의 method는 pose sequence와 textual descriptions를 통해 유연한 control을 제공하는 video를 생성하는 정교한 디자인이 갖춰져있다. 게다가 본 논문의 model은 pre-train된 T2I model의 견고한 concept generation과 composition 능력을 지닌다.

본 논문의 contribution은 다음과 같이 요약된다.

- 본 논문은 pose-controllable text-to-video generation의 새로운 task를 다루고, pose-content alignment의 학습을 유용하게 하는 LAION-Pose 데이터셋을 도입한다.

- 다양한 character video 부족 문제를 해결하기 위해, 본 논문은 pose alignment와 temporal coherence라는 두 개의 작은 문제로 task를 나눈다. 그러고 나서 다른 데이터셋으로 다른 파라미터 셋에 대해 tuning함으로써 two-stage training 메커니즘을 제안한다.

- 생성 퀄리티, text-video alignment, pose-video alignment, temporal coherence의 관점에서 본 논문의 method가 다른 baseline들보다 우월하다는 것을 실험을 통해 보인다.

2. Method

본 논문은 pose sequence와 text로부터의 appearance description로부터 현실적인 video를 생성하는 것이 목적이다. 본 논문의 method는 본 논문의 task와 맞도록 몇 가지 수정을 한 pretrain된 text-to-image model를 기초한다.

2.1 Preliminary : Latent Diffusion Models

Stable Diffusion : https://juniboy97.tistory.com/47

[평범한 학부생이 하는 논문 리뷰] High-Resolution Image Synthesis with Latent Diffusion Models (Stable Diffusion)

부스트캠프 내에서 내가 진행하고 있는 diffusion 스터디에서는 아직 SDE diffusion 논문을 읽고 있고, DDIM까지 읽고 나서 Stable Diffusion을 읽으려 했지만, 최종 프로젝트 때문에 미리 읽게 되었다. 다행

juniboy97.tistory.com

DDPM : https://juniboy97.tistory.com/46

[평범한 학부생이 하는 논문 리뷰] Denoising Diffusion Probabilistic Models (DDPM)

이번에 리뷰할 논문은 그 유명한! DDPM! Diffusion의 기초 논문들은 확실하게 이해하고 넘어가는 것이 좋다는 멘토님의 조언에 따라 이번 ddpm도 시간은 오래 걸리겠지만 최대한 꼼꼼하게 읽어서 자

juniboy97.tistory.com

이 섹션에서는 LDM과 DDPM에 대한 간단한 설명을 하는데 이에 대한 자세한 설명은 위 포스팅에서 확인할 수 있다.

2.2 Pose-guided Text-to-Video Generation

Video-Pose paired 데이터셋의 부족때문에 본 논문에서는 temporal과 control conditions를 나눈다. 본 논문의 모델은 image로부터 pose control 능력을 학습하고 video로부터 temporal consistency를 학습한다. 본 논문의 method는 다른 목적을 위한 다른 두 개의 stage의 학습을 포함한다.

Training Stage 1 : Pose-Controllable Text-to-Image Generation

이 stage에서는 pose를 제어할 수 있는 text-to-image 모델을 학습한다. 본 논문에서는 LAION 데이터셋에서 MMpose를 통해 human skeleton images를 수집한다. 이를 통해 image-text-pose 데이터셋인 LAION-Pose를 형성한다. Pre-train된 T2I model에 pose condition을 통합하기 위해, 본 논문에서는 original denoising U-Net의 모든 파라미터를 고정시키고 pose encoder로 여러 개의 3D convolutional layer들을 활용하고 이를 U-Net의 각 block에 주입하는 방식을 제안한다. 자세하게, input pose sequence로부터 pose feature를 추출하기 위해 각 block에 이 convolutional layer를 사용한다. 그러고 나서, pose feature들은 다른 해상도로 downsample된다. 그리고 이를 위 이미지 3에서 보이는 것처럼 U-Net 모델의 각 layer에 feature를 추가함으로써 residual connection을 통해 pre-train된 U-Net에 이 additional controlling information을 주입한다. 이 residual injection 덕분에 pre-trained diffusion model의 생성 능력은 유지하면서 적은 파라미터만 update해 추가 pose-controlling information을 추가하도록 할 수 있다. 게다가 원래의 diffusion model을 복원하기 위해 residual을 모두 0으로 설정함으로써 쉽게 condition 정보를 없앨 수 있다. 본 논문에서는 주입된 파라미터를 tuning하기 위해 원래 stable diffusion 모델의 간단한 noise reconstruction loss를 사용했다.

Training Stage 2 : Video Generation via Pose-free Videos

Stage 1 모델이 유사한 pose video를 생성할 수 있지만 배경은 일치하지 않는다. 그러므로 모델을 pose-free video 데이터셋 HDVLIA로 finetune해야한다. Temporal consistent video를 생성하기 위해, 본 논문은 text-to-image 모델의 generative prior를 pose-to-video generation을 위해 활용한다. 그리고 video input을 위한 pseudo-3D convolution layer로 pretrained U-Net의 첫 convolution layer를 $1 \times 3 \times 3$ convolution kernel로 부풀리고 temporal modeling을 위해 temporal self-attention을 더한다. Temporal consistency를 더 유지하기 위해, 본 논문에서는 frame들 사이 cross-frame self-attention을 활용한다. 이전의 DDIM sampling process time step으로부터의 noise를 재사용함으로써 더 긴 video sequence를 생성하도록 만들었다. 자세히 보면, $T$ frame들이 각 시간대에 샘플링된다고 가정하면, 마지막 $\frac{T}{2}$ frame들의 noise를 다음 반복 때 prior knowledge로 더해진다. Denoising process를 통해, 생성된 긴 videos의 시간적인 일관성을 보장하기 위해 각 time step에서 noise는 prior knowledge에 더해진다는 것에 주목해야한다. 이미지 3에서 보이는 것처럼, 제안된 method는 cross-frame self-attention(SA)와 temporal SA만 tuning한다.

3. Experiments

3.1 Applications

Diverse character generation, Diverse background generation, Stylized character video generation

Multiple-characters generation

3.2 Comparison with Baselines

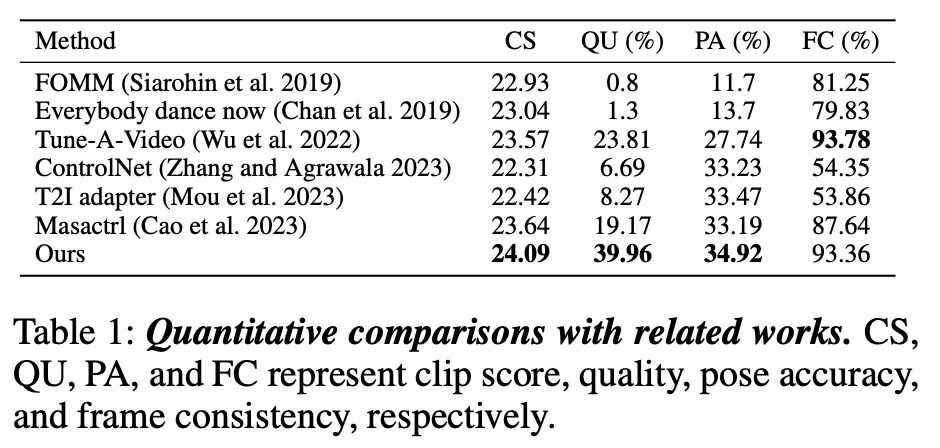

Quantitative results.

CLIP score

더 높은 CLIP score를 보임으로써 다른 방식들보다 더 좋은 video-text alignment를 보인다.

Quality

사람 평가를 통해 결과를 냈는데, 평가자들이 본 논문의 결과를 더 선호하는 것을 보인다.

Pose Accuracy

Skeleton에 대한 average precision을 통해 계산했다.

Frame Consistency

연속적인 frame들의 CLIP cosine 유사도를 통해 측정했다. 이 결과 ControlNet보다 좋은 성능을 보여 본 논문의 temporal 디자인의 필요성을 보였다. 또한 Tune-A-Video모델과 유사한 성능을 보였는데, Tune-A-Video는 input video에 의존하고 input video에 overfit할 필요가 있다. 그렇기에 일반적인 video generation model로 제공되기는 어렵다.

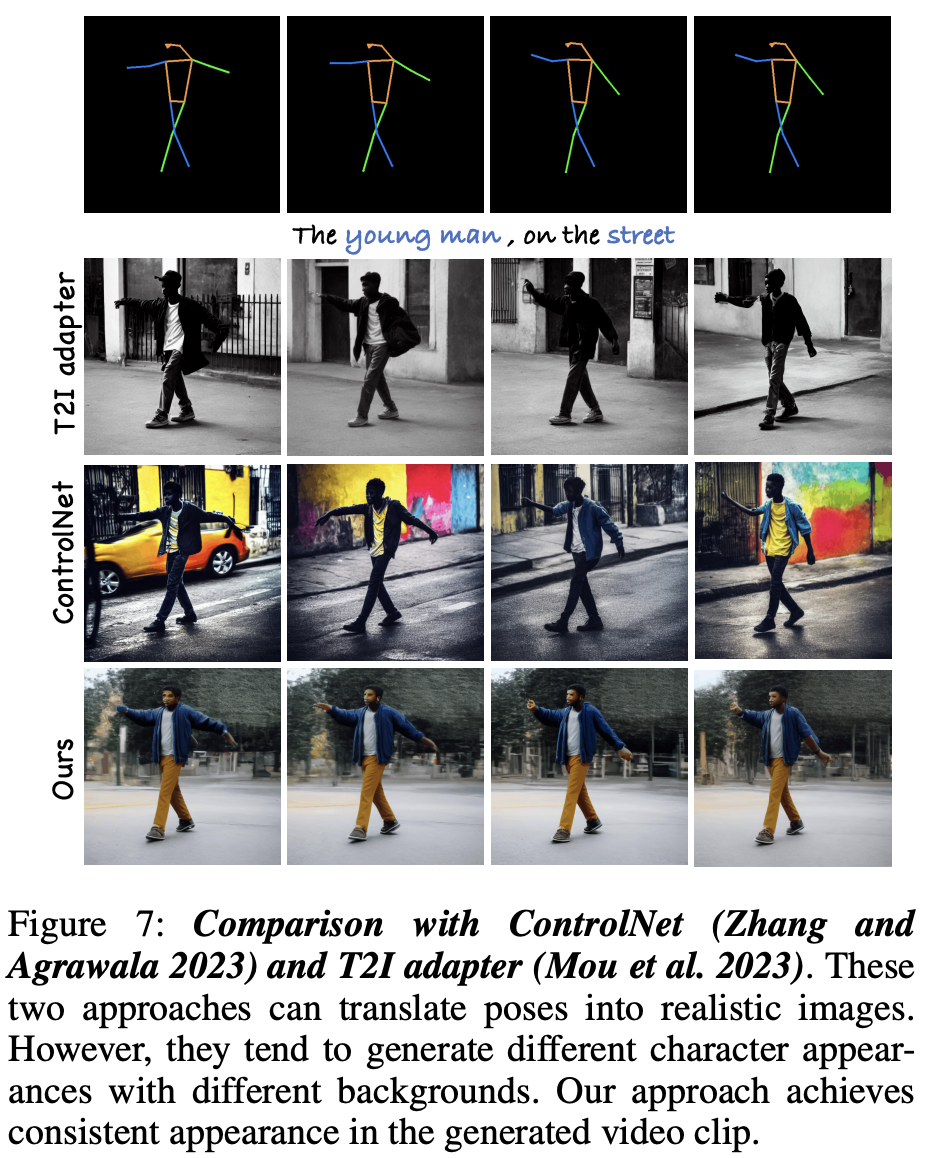

Qualtitative results

사진 5를 보면 본 논문의 method가 consistency와 artistry에서 더 좋은 것을 볼 수 있다. 또한 사진 7을 보면 본 논문의 method가 배경에 대한 inconsistency 문제를 해결하고 프레임 내 일관성을 더 잘 학습하는 것을 볼 수 있다.

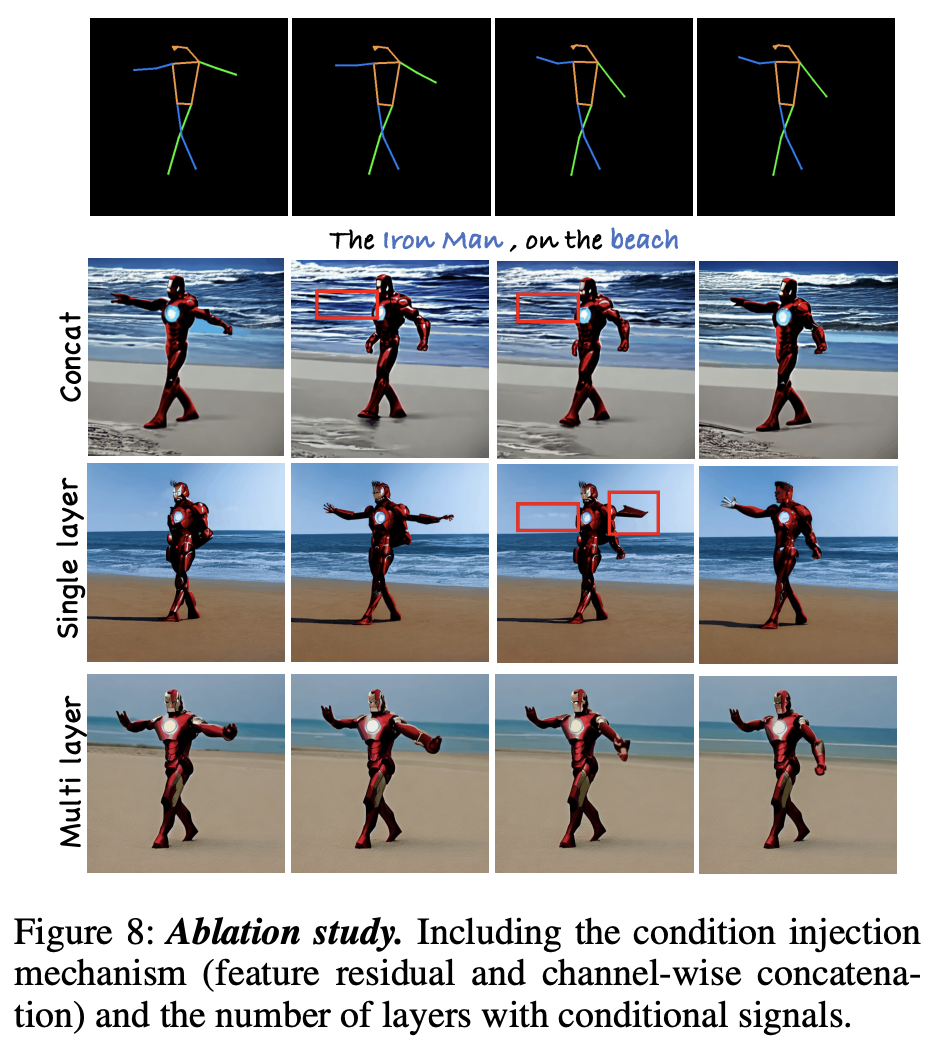

3.3 Ablation Study

Effect of residual pose encoder

본 논문에서 제안한 pose encoder는 residual 방식으로 condition을 diffusion model에 추가한다. 이번 섹션에서는 concatenate와 residual 방식을 비교한다. 사진 8의 결과를 보면 residual 방식을 이용하는 것이 결과가 좋은 것을 볼 수 있다. 논문에서는 이러한 결과가 나온 이유로 concatenation 방식은 input 채널의 수를 맞추기 위해 첫 convolutional layer를 다시 학습해야하고 이 때문에 pretrain된 모델을 손상시킨다고 말한다.

Number of layers of condition control

더 많은 layer에 control을 추가하는 것은 pose-frame alignment를 향상시킨다고 한다. 사진 8에서 결과를 확인할 수 있다.

4. Conclusion

본 논문에서는 text-editing하고 pose-controllable한 character video를 생성하는 문제를 다룬다. Pretrain된 text-to-image 모델의 semantic editing 및 composition능력 때문에 이를 변형하고 tuning한다. 그래서 본 논문은 새로운 two-stage training 구조를 제안한다. 구체적으로 첫 번째 훈련 단계에서는 pose encoder를 사용해 pose 정보를 네트워크 구조에 주입하고 pose control 이 가능한 텍스트-이미지 생성을 위해 이미지-포즈 쌍으로 학습 한다. 두 번째 훈련 단계에서는 이미지 모델을 3D 네트워크로 부풀려 pose-free 비디오에서 temporal coherence 를 학습 다. 몇 가지 새로운 설계를 통해 기존 T2I 모델의 conceptual combination 능력을 유지하면서 새롭고 창의적인 temporal coherence를 갖춘 비디오를 생성할 수 있다.